Je website sneller laten indexeren door Google?

Hoe zorg je ervoor dat je nieuwe website snel opgenomen wordt in de zoekresultaten van Google? En hoe zorg je ervoor dat nieuwe content, zoals blogs op je website, snel door Google wordt geïndexeerd? Wanneer je een nieuwe website hebt gemaakt of een nieuw blog hebt geschreven, dan wil je natuurlijk dat deze snel te vinden is in Google. Enthousiasme maakt dan al snel plaats voor ongeduld… 😉 In dit artikel zal ik 3 tips geven om je website sneller te laten indexeren door Google en dus sneller getoond te worden in de zoekresultaten.

Tip: Wil je jouw website helemaal perfect inrichten om te scoren in Google? Download dan gratis Winnen in Google!

Hoe bepaalt Google de snelheid van indexeren?

Google is een zoekmachine die probeert om alle websites op het internet te indexeren. Dat valt nog niet mee, want het internet groeit ontzettend snel en tegenwoordig zijn er al meer dan 3,5 miljard pagina’s te vinden op het internet. Al die pagina’s zijn natuurlijk niet 24 uur per dag in de gaten te houden door Google.

Google moet deze miljarden webpagina’s indexeren en dus verwerken ze niet elke dag alle wijzigingen op alle websites. Ze hebben daar een eigen prioriteit in die zij ‘cafeïne indexing’ noemen. Ze moeten enerzijds kijken naar alle nieuwe websites die verschijnen om te indexeren en anderzijds in de gaten houden wat er op alle bestaande websites wijzigt. Je zult in eerste instantie gewoon moeten afwachten totdat Google (terug) naar je website komt en jouw website of pagina indexeert. Dat proces kun je op 3 manieren versnellen:

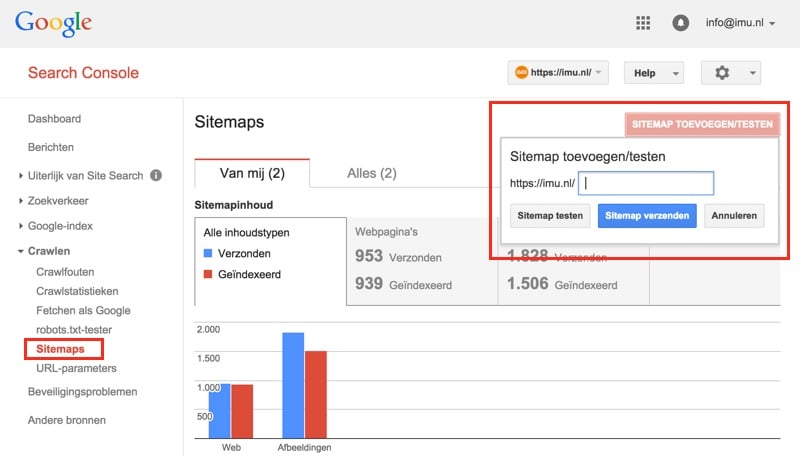

1. Werken met Google Webmaster Tools

Je kunt Google een handje gaan helpen door je website met Google te laten communiceren. Je kunt Google via Webmaster Tools automatisch een seintje geven wanneer je iets aan je website toevoegt of weghaalt. Dit doe je door een (XML) sitemap van je website te genereren en vervolgens op te geven in Webmaster Tools. Zorg ervoor dat je sitemap automatisch door je website gegenereerd en bijgewerkt wordt, dan automatiseer je dit proces namelijk volledig.

Weet je niet zeker of je sitemap op dit moment goed werkt? Controleer het dan met één van deze SEO checks.

2. Zorgen voor backlinks en links vanuit social media

Wanneer je website of nieuwe content online staat en je hebt een seintje gegeven aan Webmaster Tools dan heb je de basis gelegd, de rode loper ligt dan uit voor zowel Google als voor bezoekers. Om beide partijen snel te bereiken en de waarde van je website te benadrukken moet je gaan zorgen voor “sociale aanbevelingen”, oftewel: zorgen dat anderen het over je hebben en naar je verwijzen.

Vanuit de basisfilosofie van Google geldt: Hoe meer er naar je verwezen wordt, des te waardevoller je bent. In eerste instantie ging dat op voor de hoeveelheid backlinks naar je website, later kwam daar ook de kwaliteit en relevantie van die backlinks bij en tegenwoordig zie je dat links vanuit social media (sociale populariteit) ook meewegen. Niet alle mensen die zich met zoekmachine optimalisatie bezig houden zijn het eens over de waarde van social media voor SEO.

Ik raad je aan om bij een nieuwe website met beide aan de slag te gaan (zowel backlinks als sociale links) en bij nieuwe content, zoals blogs, op je website alleen nog te focussen op de social media kant. Wanneer ik een nieuw blogbericht op mijn website plaats dan doe ik steevast dit:

- Het bericht “liken” met mijn eigen Facebookprofiel

- Een los bericht (+ link naar het blogbericht) op het prikbord van mijn profiel zetten

- Een los bericht (+ link naar het blogbericht) op het prikbord van mijn Fanpage zetten

- Een los bericht (+ link) in relevante Facebook groepen plaatsen (niet altijd relevant)

- Een tweet plaatsen op mijn Twitterprofiel (+ link naar het blogbericht)

- Het bericht een +1 geven met mijn Google plus profiel

- Een los bericht (+ link naar het blogbericht) op mijn Google plus profiel plaatsen

- Een los bericht (+ link naar het blogbericht) op mijn Google plus bedrijfspagina plaatsen

Let op Google plus!

Met name Google plus zal de komende tijd een steeds sterkere invloed krijgen op de zoekresultaten en snelheid van indexeren. Natuurlijk doe je mij er een groot plezier mee wanneer je hieronder even op de +1 knop wilt klikken 😉

Extra tip: Ook je SEO structuur en met name je (geautomatiseerde) interne links dragen bij aan de snelheid van indexeren. Wanneer je op enkele “sterke” pagina’s op jouw website (die reeds geïndexeerd zijn) een linkje naar je nieuwe pagina plaatst dan zul je zien dat je sneller opgepakt wordt.

Bouwen aan een website reputatie bij Google

Zoekmachine optimalisatie kun je ook zien als het opbouwen van een reputatie bij Google. Op het moment dat je website voor het eerst het daglicht ziet begin je met een schone lei bij Google. Vanaf dat moment bouw je aan je reputatie.

Hoe meer je (goed) doet, des te sterker je reputatie wordt.

Hoe meer je fout doet (blackhat SEO), des te slechter je reputatie wordt.

Hoe beter je website reputatie is, des te sneller je geïndexeerd wordt en des te hoger je scoort.

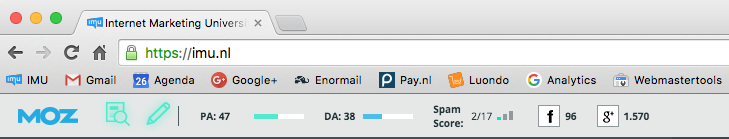

Met de toolbar van MOZ kun je snel je domein- en pagina autoriteit bekijken om te zien hoe sterk je reputatie is:

Wanneer je wilt dat je reputatie snel gaat groeien dan raad ik je aan om te focussen op de menselijke factor in je website. In mijn ogen bestaat dat uit de volgende speerpunten:

- Een goede contentstrategie (regelmatig bloggen, focus op waarde)

- Hoge interactie (reaties van lezers op je blog)

- Social media invloeden (veel likes, tweets, +1’s en sociale betrokkenheid)